- Велика мовна модель Google PaLM 2 використовує майже в п’ять разів більше текстових даних для навчання, ніж її попередник, LLM, повідомляє CNBC.

- Оголошуючи PaLM 2 минулого тижня, Google заявив, що ця модель менша за попередню PaLM, але використовує більш ефективну «технологію».

- Відсутність прозорості щодо навчальних даних у моделях ШІ стає дедалі гострішою темою серед дослідників.

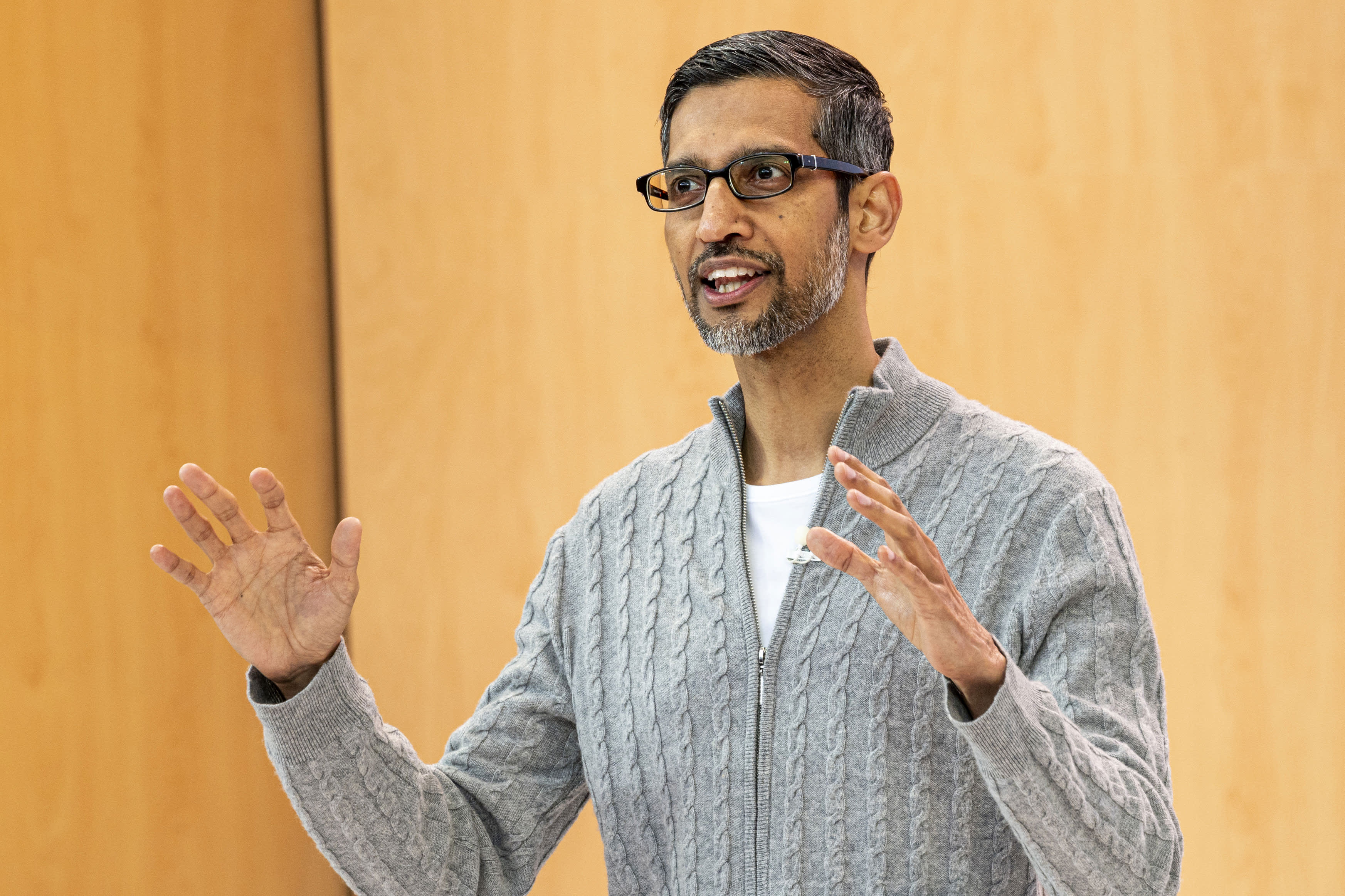

Сундар Пічаї, генеральний директор Alphabet Inc. , під час конференції розробників Google I/O у Маунтін-В’ю, Каліфорнія, у середу, 10 травня 2023 р.

Девід Пол Морріс | Блумберг | Getty Images

CNBC дізнався, що нова велика мовна модель Google, яку компанія анонсувала минулого тижня, використовує майже в п’ять разів більше навчальних даних, ніж її попередниця з 2022 року, що дозволяє їй виконувати більш просунуті завдання з кодування, математики та творчого письма.

Згідно з внутрішніми документами, з якими ознайомився CNBC, PaLM 2, нова модель загальнодоступної великої мови (LLM), представлена на Google I/O, була навчена на 3,6 трильйонах токенів. Токени, які є рядками слів, є важливим будівельним блоком для навчання LLM, оскільки вони вчать модель передбачати наступне слово, яке з’явиться в послідовності.

Попередня версія Google PaLM, яка розшифровується як Pathways Language Model, була випущена в 2022 році та навчена на 780 мільярдах токенів.

Хоча Google прагнув продемонструвати потужність своєї технології штучного інтелекту та те, як її можна інтегрувати в пошук, електронну пошту, обробку текстів і електронні таблиці, компанія не бажала оприлюднювати обсяг чи інші деталі своїх навчальних даних. OpenAI, новатор ChatGPT, який підтримується Microsoft, також зберіг у таємниці подробиці останньої мови LLM під назвою GPT-4.

Компанії кажуть, що причиною відсутності інформації є конкурентний характер бізнесу. Google і OpenAI поспішають залучити користувачів, які, можливо, захочуть шукати інформацію за допомогою чат-ботів замість традиційних пошукових систем.

Але оскільки гонка озброєнь ШІ триває, дослідницьке співтовариство закликає до більшої прозорості.

З моменту відкриття PaLM 2 Google заявив, що нова модель менша за попередні LLM, що важливо, оскільки це означає, що технологія компанії стає ефективнішою при виконанні більш складних завдань. PaLM 2 навчається, згідно з внутрішньою документацією, на 340 мільярдах параметрів, що свідчить про складність моделі. Початковий PaLM навчається на 540 мільярдах параметрів.

Google не відразу прокоментувала цю історію.

Google Він сказав У публікації в блозі про PaLM 2 модель використовує «нову техніку», яка називається оптимізацією обчислювального масштабу. Це робить LLM «більш ефективним із кращою загальною продуктивністю, включаючи швидший висновок, менше параметрів обслуговування та нижчу вартість обслуговування».

Анонсуючи PaLM 2, Google підтвердив попередні повідомлення CNBC про те, що модель навчена 100 мовам і виконує широкий спектр завдань. Він уже використовується для роботи 25 функцій і продуктів, включаючи експериментальний чат-бот компанії Bard. Він доступний у чотирьох розмірах, від найменшого до найбільшого: гекон, видра, бізон і єдиноріг.

PaLM 2 є потужнішим, ніж будь-яка існуюча модель, виходячи з публічних розкриттів. LLM у Facebook називається LLaMA, тобто оголосити У лютому його навчили на 1,4 трильйона токенів. Востаннє OpenAI ділився обсягом навчання ChatGPT з GPT-3, коли компанія заявила, що за цей час навчила 300 мільярдів кодів. OpenAI випустив GPT-4 у березні та заявив, що він демонструє «продуктивність на рівні людини» в кількох професійних тестах.

LaMDA, LLM розмова, що Google стопа Згідно з останніми документами, з якими ознайомився CNBC, два роки тому і рекламувався в лютому разом з Bard, він був навчений на 1,5 трлн токенів.

Оскільки нові програми штучного інтелекту швидко досягають мейнстріму, тож дебати щодо базової технології зростають.

Мехді Ельмохамаді, старший науковий співробітник Google, У лютому він подав у відставку Про непрозорість компанії. У вівторок генеральний директор OpenAI Сем Альтман дав свідчення на слуханнях судового підкомітету Сенату з конфіденційності та технологій і погодився з законодавцями, що потрібна нова система для боротьби зі штучним інтелектом.

«Для технології, яка є настільки новою, нам потрібна нова структура», — сказав Альтман. «Звичайно, такі компанії, як наша, несуть велику відповідальність за інструменти, які ми випускаємо у світ».

— Джордан Новетт з CNBC взяв участь у цьому звіті.

Він спостерігає: Сем Альтман, генеральний директор OpenAI, закликав до управління ШІ

“Загальний ніндзя в соціальних мережах. Інтроверт. Творець. Шанувальник телебачення. Підприємець, що отримує нагороди. Веб-ботанік. Сертифікований читач”